Kunstig intelligens før og nå

Ingen satellittmålinger her i dag. I stedet tar vi et tilbakeblikk på en ung forskers første møte med kunstig intelligens.

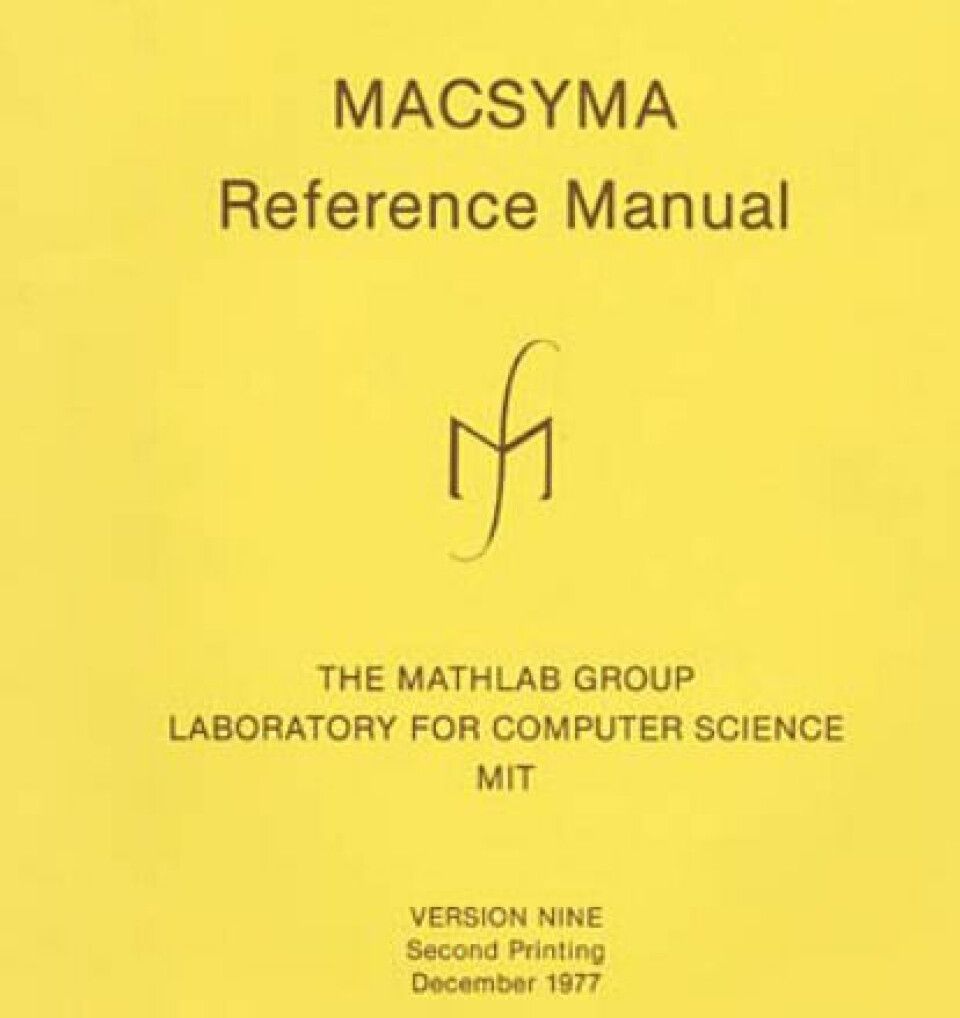

Sommeren 1982 kom jeg, som vernepliktig soldat, på jobbintervju for en forskerstilling på Forsvarets forskningsinstitutt (FFI). Og da fikk jeg se noe merkelig: Borte i en krok stod en dataskjerm som viste matematiske likninger og figurer. Jeg ble forklart at skjermen var koblet til en stor datamaskin ved MIT i Boston, USA, via noe som het «Arpanet». Og på datamaskinen ved MIT ble det kjørt et program som het MACSYMA, som kunne gjøre symbolsk matematikk, ikke bare regne med tall.

Jeg fikk noen andre jobbtilbud også den høsten, men FFI blåste andre potensielle arbeidsgivere av banen med dette lille innblikket i det som jeg oppfattet som «kunstig intelligens».

Årsaken til at jeg skriver dette nå, er at jeg nylig har lest Inga Strümkes utmerkete bok «Maskiner som tenker» (2023), og det ga meg lyst til å belyse fagfeltets historie litt fra mitt eget perspektiv.

Arpanet var forløperen til Internet, og jeg skjønte med en gang at denne teknologien ville bli veldig nyttig – for forskere og ingeniører. Men at folk flest med tiden skulle komme til å bruke Internet som sin primære samhandlingsplattform og arena for underholdning, kjøp og salg – det tok det mange år før jeg forstod. Forskere kan være ganske trege til å tenke utenfor boksen.

MACSYMA var et av de første eksemplene på at datamaskinen utmerket godt kunne gjøre noe man lenge trodde var et tegn på menneskelig intelligens, nemlig avansert matematikk. Senere skulle datamaskinene feie mennesket av banen på flere områder der jeg var interessert, deriblant sjakk.

1980-tallet

Strümke skriver i sin bok at feltet AI/KI har opplevd flere vintre, med påfølgende våroppblomstringer. Selv husker jeg godt da ekspertsystem-bølgen kom utover på 1980-tallet, med stort fokus på programmeringsspråkene LISP og Prolog. På FFI bygget vi et matematisk ekspertsystem for kurve-analyse oppå MACSYMA, vi skrev FFI-notater om kunstig intelligens, og vi deltok på stiftelsesmøtet i oktober 1985 for Norsk forening for kunnskapsteknologi (The Norwegian Society for Artificial Intelligence).

I artikkelen «Symbolmanipulasjon – på vei ut fra laboratoriet» (DATATID Nr. 3/1985) skrev jeg:

«Vi runder av med å påpeke det paradoksale i at mens matematikken gjerne har vært ansett som det tyngste faget i skolen, så er altså nettopp dette det første faget vi ser bli overtatt av datamaskinene. Vi har nok flere overraskelser i vente …»

Den daværende norske datamaskinprodusenten Norsk Data etablerte sammen med et britisk selskap et nytt firma - Racal-Norsk - som skulle utvikle og selge datamaskiner for kjøring av AI-funksjoner i LISP sammen med ordinære programmer. Det var snakk om å kjøpe inn en slik maskin ved FFI, men utviklingen tok en annen vei. Og så kom det en AI-vinter.

Vi spoler fram til 1986, og artikkelen «Dataforskning: Store mål og store penger» (DATATID Nr. 4/86), der jeg skriver i avslutningen:

«Selvsagt skjer det også andre positive ting i Norge. Regjeringen har uttalt at informasjonsteknologi er et område der det skal satses, og det kommende medlemskapet i European Space Agency (ESA) vil være en viktig vitamininnsprøytning også i datakretser. Det er ingen grunn til å tro at vi går kjedelige data-år i vente.»

I årene deretter hadde jeg mest faglig fokus på satellittene. Men i 1989 skrev jeg artikkelen «Hva kan datamaskinen gjøre bedre enn deg og meg?» i tidsskriftet Populærvitenskapelig Magasin. Derfra må gjengis følgende sitat, fra avsnittet som handlet om tekstbehandling:

«Ingen datamaskin kunne ha skrevet denne artikkelen»

Ikke den gangen, nei …

1990-tallet

Vi spoler videre framover i tid. Som en slags motpol til ekspertsystemene, så kom de nevrale nettene for alvor på 1990-tallet. Mens ekspertsystemene måtte fortelles alle reglene, skulle de nevrale nettene «leke og lære», bare de fikk nok data å trene seg på. FFI tok selvsagt temaet på alvor, og satte i 1991 ned en arbeidsgruppe som kjørte ti seminarer, og laget en tykk ugradert rapport: «Oppsummering fra studiegruppen for nevrale nett ved FFI» (Gjønnes et al, FFI/RAPPORT-92/7015). Selv ledet jeg to av seminarene, og det har vært interessant å lese rapporten på nytt i år som pensjonist, i lys av Strümkes bok.

Konklusjonen i rapporten fra 1992 innledes slik:

«Studiegruppen mener at nevrale nett i dag er en veldefinert teknologi med et relativt godt metodisk grunnlag, og med demonstrert evne til å løse problemer ute i den virkelige verden innenfor de krav til ytelse, hastighet og robusthet som settes av denne. Selv om det metodiske grunnlaget kan karakteriseres som godt, så synes mye av teorien å være vanskelig å anvende på praktiske problemer.»

På sett og vis bommet ikke arbeidsgruppen så mye når det gjelder de militære anvendelsene. Maskinlæring med nevrale nett på store datamengder, ble en del av virkeligheten - ikke minst når det gjelder satellittbilder. Men man skal lete lenge i den FFI-rapporten for å finne noe om Generativ AI, språkmodeller, diffusjonsmodeller og digital kunst. For å si det enkelt: Jeg så aldri ChatGPT eller DALL-E komme.

2024:

Vel, over til vår egen tid. Jeg har nylig spurt ChatGPT om framtidsutsiktene for forskningsblogger. Her er svaret:

«Overall, while the core purpose of science blogs - to communicate scientific discoveries and concepts to a broader audience - is unlikely to change, the format, presentation, and technological integration of these blogs will continue to evolve to meet the changing needs and preferences of readers.»

Bra! Da ses vi igjen her på bloggen om noen uker.